تحلیل مؤلفههای اصلی محتویات جزئیات[ویرایش] محدودیتهای تحلیل مولفههای اصلی[ویرایش] محاسبه مولفههای اصلی با استفاده از ماتریس کواریانس[ویرایش] نرمافزارها[ویرایش] جستارهای وابسته[ویرایش] پانویس[ویرایش] منابع[ویرایش] منوی ناوبریComputer Vision Library"On Lines and Planes of Closest Fit to Systems of Points in Space".Principal Component AnalysisSpringer Series in StatisticsA tutorial on Principa Component Analysisو

Multi tool use

میانگینمیانگین حسابیمیانگین هندسیمیانگین همسازمیانهمددامنهانحراف معیارضریب تغییراتصدکدامنه بین چارکیواریانسچولگیکشیدگیگشتاورال-گشتاوردادههای گروهبندیشدهتوزیع فراوانیجدول پیشایندینمودار میلهایدونمودارهنمودار جعبهاینمودار کنترلهمبستگینگارنمودار جنگلیبافتنگارنمودار Q-Qنمودار توالینمودار پراکنشنمودار ساقه و برگنمودار راداریاندازه تأثیرخطای استانداردتوان آماریتعیین اندازه نمونهطراحی آزمایشآزمایش تصادفیانتساب تصادفیتکرار آزمایشبلوکبندیآزمایش عاملیطراحی بهینهتوزیع نمونهگیریآماره بسندهفراتحلیلآماره ترتیبیآماره کاوشیمقدار رکوردکامل بودنخانواده نماییآزمون جایگشتیآزمون تصادفیدنتوزیع نمونهایبوتاسترپینگآماره Uکاراییآمار باثباتاحتمال بیزیاحتمال پیشیناحتمال پسینبازه مورد قبولعامل بیزبرآوردگر بیزیبرآوردگر بیشینهگر احتمال پسینضریب همبستگی پیرسونهمبستگی جزئیاختلاطضریب تشخیصرگرسیون ساده خطی(en)کمینه مربعات خطیمدل خطی عمومی(en)رگرسیون خطی بیزی(en)خانواده نماییرگرسیون لجستیکرگرسیون دوجملهای(en)پواسونکاپای کوهنجدول پیشایندیمدل گرافیرگرسیون پواسونآزمون مکنمارتجزیهتخمین روندفرایند ماناتصحیح فصلیبودنهموارسازی نمایی(en)همجمعیعلیت گرانجرآماره Q(en)آماره دوربین-واتسون(en)خودهمبستگیتابع خودهمبستگی جزئی(en)تابع خودهمبستگی تقاطعی(en)آرمامدل آریماگارچاتورگرسیو برداریتخمین طیفیتحلیل فوریهموجکتابع بقا(en)برآوردگر کاپلان-مهیرآزمون لگرتبهای(en)نرخ خرابیمدل خطرهای متناسب(en)مدل زمان خرابی شتابیده(en)بیوانفورماتیکزیستسنجشیکارآزمایی بالینیمطالعاتهمهگیرشناسیآمار پزشکیآکچوئریسرشماریآمار جرم(en)آمار جمعیتشناسی(en)اقتصادسنجیآمار ملی(en)آمار رسمی(en)جامعه آماریروانسنجی

آمار چندمتغیرهتجزیه مقادیر منفردتحلیل دادهتقلیل ابعاددادهکاویفشردهسازی دادههایادگیری ماشینی

فضای برداریکاهش ابعادمجموعهٔ دادههاکارل پیرسونتجزیه مقدارهای ویژهٔماتریس کواریانستبدیل خطیمتعامددستگاه مختصاتماتریس دادهمیانگین تجربیتجزیه مقدارهای منفردترکیب خطیماتریسماتریس فاصلهمقادیر ویژهبردارهای ویژهماتریس قطریانحراف معیار

تحلیل مؤلفههای اصلی

پرش به ناوبری

پرش به جستجو

تحلیل مؤلفههای اصلی (Principal Component Analysis - PCA) تبدیلی در فضای برداری است، که بیشتر برای کاهش ابعاد مجموعهٔ دادهها مورد استفاده قرار میگیرد.

تحلیل مؤلفههای اصلی در سال ۱۹۰۱ توسط کارل پیرسون[۱] ارائه شد. این تحلیل شامل تجزیه مقدارهای ویژهٔ ماتریس کواریانس میباشد.

محتویات

۱ جزئیات

۲ محدودیتهای تحلیل مولفههای اصلی

۳ محاسبه مولفههای اصلی با استفاده از ماتریس کواریانس

۳.۱ محاسبه میانگین تجربی و نرمالسازی دادهها

۳.۲ محاسبه ماتریس کواریانس

۳.۳ محاسبه مقادیر ویژه ماتریس کواریانس و بازچینی بردارهای ویژه

۳.۴ انتخاب زیرمجموعهای از بردارهای ویژه به عنوان پایه

۳.۵ انتقال داده به فضای جدید

۴ نرمافزارها

۵ جستارهای وابسته

۶ پانویس

۷ منابع

جزئیات[ویرایش]

تحلیل مؤلفههای اصلی در تعریف ریاضی[۲] یک تبدیل خطی متعامد است که داده را به دستگاه مختصات جدید میبرد بهطوریکه بزرگترین واریانس داده بر روی اولین محور مختصات، دومین بزرگترین واریانس بر روی دومین محور مختصات قرار میگیرد و همینطور برای بقیه.

تحلیل مؤلفههای اصلی میتواند برای کاهش ابعاد داده مورد استفاده قرار بگیرد، به این ترتیب مؤلفههایی از مجموعه داده را که بیشترین تأثیر در واریانس را دارند حفظ میکند.

برای ماتریس داده XTdisplaystyle X^T با میانگین تجربی صفر، که هر سطر یک مجموعه مشاهده و هر ستون دادههای مربوط به یک شاخصه است، تحلیل مؤلفههای اصلی به صورت زیر تعریف میشود:

YT=XTW=VΣdisplaystyle Y^T=X^TW=VSigma

بهطوریکه VΣWTdisplaystyle VSigma W^T تجزیه مقدارهای منفرد ماتریس XTdisplaystyle X^T میباشد.

محدودیتهای تحلیل مولفههای اصلی[ویرایش]

استفاده از تحلیل مؤلفههای اصلی منوط به فرضهایی است که در نظر گرفته میشود. از جمله:

- فرض خطی بودن

فرض بر این است که مجموعه داده ترکیب خطی پایههایی خاص است.

- فرض بر این که میانگین و کواریانس از نظر احتمالاتی قابل اتکا هستند.

- فرض بر این که واریانس شاخصه اصلی دادهاست.

محاسبه مولفههای اصلی با استفاده از ماتریس کواریانس[ویرایش]

بر اساس تعریف ارائه شده از تحلیل مؤلفههای اصلی، هدف از این تحلیل انتقال مجموعه داده X با ابعاد M به داده Y با ابعاد L است. بنابرین فرض بر این است که ماتریس X از بردارهای X1…XNdisplaystyle X_1dots X_N تشکیل شدهاست که هر کدام به صورت ستونی در ماتریس قرار داده شدهاست. بنابرین با توجه به ابعاد بردارها (M) ماتریس دادهها به صورت M×Ndisplaystyle Mtimes N است.

محاسبه میانگین تجربی و نرمالسازی دادهها[ویرایش]

نتیجه میانگین تجربی، برداری است که به صورت زیر به دست میآید:

- u[m]=1N∑i=1NX[m,i]displaystyle u[m]=frac 1Nsum _i=1^NX[m,i]

که بهطور مشخص میانگین تجربی روی سطرهای ماتریس اعمال شدهاست.

سپس ماتریس فاصله تا میانگین به صورت زیر به دست میآید:

B=X−uhdisplaystyle B=X-uh

که h برداری با اندازه 1×Ndisplaystyle 1times N با مقدار ۱ در هرکدام از درایهها است.

محاسبه ماتریس کواریانس[ویرایش]

ماتریس کواریانس C با ابعاد M×Mdisplaystyle Mtimes M به صورت زیر به دست میآید:

- C=E[B⊗B]=E[B⋅B∗]=1NB⋅B∗displaystyle C=mathbb E [Botimes B]=mathbb E [Bcdot B^ast ]=frac 1NBcdot B^ast

- بهطوری که:

Edisplaystyle mathbb E میانگین حسابی است.

⊗displaystyle otimes ضرب خارجی است.

B∗displaystyle B^ast ماتریس ترانهاده مزدوج ماتریس Bdisplaystyle B است.

محاسبه مقادیر ویژه ماتریس کواریانس و بازچینی بردارهای ویژه[ویرایش]

در این مرحله، مقادیر ویژه و بردارهای ویژه ماتریس کواریانس، Cdisplaystyle C، به دست میآید.

- V−1CV=Ddisplaystyle V^-1CV=D

V ماتریس بردارهای ویژه و D ماتریس قطری است که درایههای قطر آن مقادیر ویژه هستند.

آنجنان که مشخص است، هر مقدار ویژه متناظر با یک بردار ویژه است. به این معنا که ماتریس V ماتریسی M×Mdisplaystyle Mtimes M است که ستونهای آن بردارهای ویژه میباشند و بردار ویژه Vqdisplaystyle V_q در ستون qام قرار دارد و مقدار ویژه qام یعنی درایهٔ λq=Dq,qdisplaystyle lambda _q=D_q,q متناظر با آن است.

بازچینی بردارهای ویژه بر اساس اندازهٔ مقادیر ویژه متناظر با آنها صورت میگیرد. یعنی بر اساس ترتیب کاهشی مقادیر ویژه، بردارهای ویژه بازچینی میشوند. یعنی p≤q⇒λp≤λqdisplaystyle pleq qRightarrow lambda _pleq lambda _q

انتخاب زیرمجموعهای از بردارهای ویژه به عنوان پایه[ویرایش]

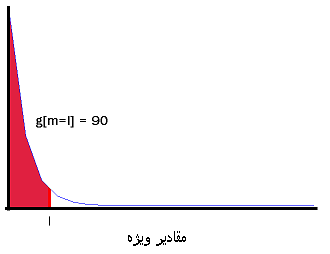

انتخاب زیرمجموعهای از بردارهای ویژه با تحلیل مقادیر ویژه صورت میگیرد. زیرمجموعه نهایی با توجه به بازچینی مرحله قبل به صورت V1…Vldisplaystyle V_1dots V_l انتخاب میشود. در اینجا میتوان از انرژی تجمعی استفاده کرد که طبق آن

- g[m]=∑q=1mλqdisplaystyle g[m]=sum _q=1^mlambda _q

انتخاب l باید به صورتی باشد که حداقل مقدار ممکن را داشته باشد و در عین حال g مقدار قابل قبولی داشته باشد. بهطور مثال میتوان حداقل l را انتخاب کرد که

- g[m=l]≤90%displaystyle g[m=l]leq 90%

بنابرین خواهیم داشت:

- W[p,q]=V[p,q],p=1…M,q=1…ldisplaystyle W[p,q]=V[p,q],p=1dots M,q=1dots l

انتقال داده به فضای جدید[ویرایش]

برای این کار ابتدا تبدیلات زیر انجام میگیرد:

ماتریس sM,1displaystyle s_M,1 انحراف معیار مجموعه دادهاست که میتواند به صورت زیر به دست بیاید:

- s[i]=C[i,i]displaystyle s[i]=sqrt C[i,i]

سپس داده به صورت زیر تبدیل میشود:

Z=Bsdisplaystyle Z=frac Bs'

که ماتریسهای Cdisplaystyle C و Bdisplaystyle B در بالا توضیح داده شدهاند.

دادهها میتوانند به ترتیب زیر به فضای جدید برده شوند:

- Y=W∗.Zdisplaystyle Y=W^ast .Z

نرمافزارها[ویرایش]

- در نرمافزار متلب تابع princomp مؤلفههای اصلی را بازمیگرداند که در نسخههای جدید، تابع pca جایگزین آن شدهاست.

- Computer Vision Library

- Eviews

جستارهای وابسته[ویرایش]

- تحلیل مولفههای مستقل

- تحلیل تفکیک خطی

- تجزیه مقدارهای منفرد

- فشردهسازی دادهها

- تحلیل تناظر

- فاکتورگیری نامنفی ماتریس

پانویس[ویرایش]

↑ Pearson, K. (1901). "On Lines and Planes of Closest Fit to Systems of Points in Space". Philosophical Magazine 2 (6): 559–572.

↑ Jolliffe I.T. Principal Component Analysis, Series: Springer Series in Statistics, 2nd ed. , Springer, NY, 2002, XXIX, 487 p. 28 illus. ISBN 978-0-387-95442-4[javascript:]

منابع[ویرایش]

- Lindsay I Smith, A tutorial on Principa Component Analysis

ردهها:

- آمار چندمتغیره

- تجزیه مقادیر منفرد

- تحلیل داده

- تقلیل ابعاد

- دادهکاوی

- فشردهسازی دادهها

- یادگیری ماشینی

(window.RLQ=window.RLQ||[]).push(function()mw.config.set("wgPageParseReport":"limitreport":"cputime":"0.296","walltime":"0.400","ppvisitednodes":"value":2305,"limit":1000000,"ppgeneratednodes":"value":0,"limit":1500000,"postexpandincludesize":"value":318549,"limit":2097152,"templateargumentsize":"value":35428,"limit":2097152,"expansiondepth":"value":16,"limit":40,"expensivefunctioncount":"value":33,"limit":500,"unstrip-depth":"value":0,"limit":20,"unstrip-size":"value":2471,"limit":5000000,"entityaccesscount":"value":0,"limit":400,"timingprofile":["148.37% 239.251 15 الگو:Navbox","100.00% 161.249 1 -total"," 73.46% 118.460 1 الگو:آمار"," 70.18% 113.171 1 الگو:Navbox_with_collapsible_groups"," 23.58% 38.029 33 الگو:پم"," 12.02% 19.386 3 الگو:سخ"," 6.56% 10.576 1 الگو:پانویس"," 3.51% 5.666 1 الگو:پایان_چپچین"," 3.04% 4.903 1 الگو:چپچین"," 2.43% 3.911 1 الگو:ISBN"],"scribunto":"limitreport-timeusage":"value":"0.039","limit":"10.000","limitreport-memusage":"value":1808490,"limit":52428800,"cachereport":"origin":"mw1322","timestamp":"20190414001820","ttl":2592000,"transientcontent":false););"@context":"https://schema.org","@type":"Article","name":"u062au062du0644u06ccu0644 u0645u0624u0644u0641u0647u200cu0647u0627u06cc u0627u0635u0644u06cc","url":"https://fa.wikipedia.org/wiki/%D8%AA%D8%AD%D9%84%DB%8C%D9%84_%D9%85%D8%A4%D9%84%D9%81%D9%87%E2%80%8C%D9%87%D8%A7%DB%8C_%D8%A7%D8%B5%D9%84%DB%8C","sameAs":"http://www.wikidata.org/entity/Q2873","mainEntity":"http://www.wikidata.org/entity/Q2873","author":"@type":"Organization","name":"u0645u0634u0627u0631u06a9u062au200cu06a9u0646u0646u062fu06afu0627u0646 u067eu0631u0648u0698u0647u0654 u0648u06ccu06a9u06ccu200cu0645u062fu06ccu0627","publisher":"@type":"Organization","name":"Wikimedia Foundation, Inc.","logo":"@type":"ImageObject","url":"https://www.wikimedia.org/static/images/wmf-hor-googpub.png","datePublished":"2008-06-11T18:49:52Z","dateModified":"2019-02-18T21:12:48Z","image":"https://upload.wikimedia.org/wikipedia/fa/9/98/%D8%AA%D8%AD%D9%84%DB%8C%D9%84_%D9%85%D9%88%D9%84%D9%81%D9%87%E2%80%8C%D9%87%D8%A7%DB%8C_%D8%A7%D8%B5%D9%84%DB%8C_%D8%A8%D8%A7_%D9%85%D8%AA%D9%85%D8%AA%DB%8C%DA%A9%D8%A7-%D8%A7%DA%98%D8%AF%D8%B1%DB%8C.png"(window.RLQ=window.RLQ||[]).push(function()mw.config.set("wgBackendResponseTime":117,"wgHostname":"mw1247"););6I9YC,X t,xfy6,haF,H m,p,k 4UqTiOvY,aTwNCG S,X

![displaystyle u[m]=frac 1Nsum _i=1^NX[m,i]](https://wikimedia.org/api/rest_v1/media/math/render/svg/37836d37aa0d3cce9b68dd60b5c213d1a9805c06)

![displaystyle C=mathbb E [Botimes B]=mathbb E [Bcdot B^ast ]=frac 1NBcdot B^ast](https://wikimedia.org/api/rest_v1/media/math/render/svg/edbe4809b1eaa7822531811761f2beb42a9f090e)

![displaystyle g[m]=sum _q=1^mlambda _q](https://wikimedia.org/api/rest_v1/media/math/render/svg/9a2d77ec0d0aed1697eb63290ede1171467beeca)

![displaystyle g[m=l]leq 90%](https://wikimedia.org/api/rest_v1/media/math/render/svg/2934f8091ff72d70585660f107526daed49b6459)

![displaystyle W[p,q]=V[p,q],p=1dots M,q=1dots l](https://wikimedia.org/api/rest_v1/media/math/render/svg/a3a04551425e467e5c59e3354cd9d1f7c9b78c75)

![displaystyle s[i]=sqrt C[i,i]](https://wikimedia.org/api/rest_v1/media/math/render/svg/e2093f7377e953a4e61c0b879f04b9c092b5d25c)